Intelligenza Artificiale. L’ultima rivoluzione?

Intelligenza Artificiale. L’ultima rivoluzione?

Il termine Intelligenza Artificiale è stato coniato nel 1956, quando un gruppo di quattro scienziati informatici di provenienza accademica e industriale hanno organizzato al Dartmouth College di Hanover, negli Stati Uniti, il primo convegno con l’obiettivo di “procedere sulla base della congettura che ogni aspetto dell’apprendimento o qualsiasi altra caratteristica dell’intelligenza possa in linea di principio essere descritto così precisamente che si possa costruire una macchina per simularlo”.

(dal documento di presentazione del convegno preparato dagli organizzatori)

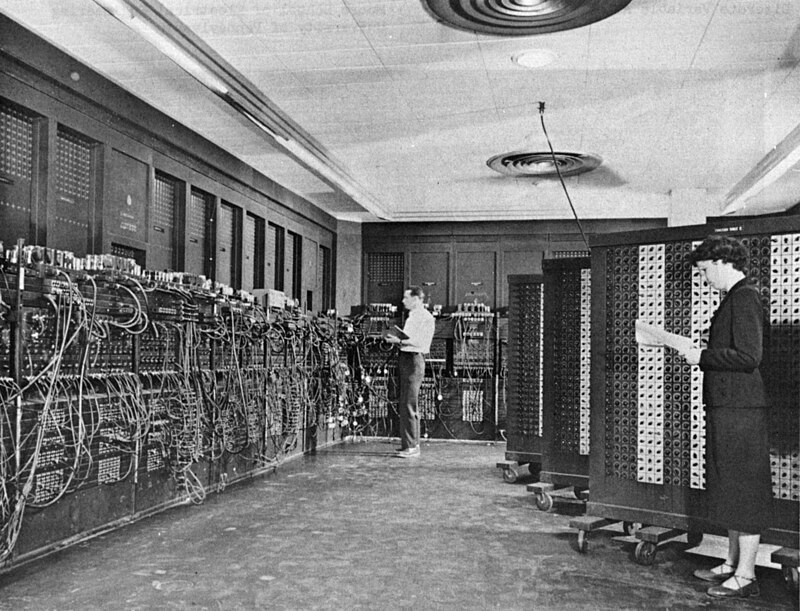

Obiettivo ambizioso per l’epoca! Il moderno computer a programma memorizzato, caratterizzato dalla cosidetta “Architettura di von Neumann”, era nato solo nel 1950, e nessuno dei grandi computer (probabilmente qualche decina) installati al mondo, macchine a valvole, quindi molto lente, con alcuni Kb di memoria, aveva prestazioni neanche lontanamente paragonabili al più antiquato degli smartphone che la maggioranza dell’umanità usa oggi.

Ma di strada l’informatica, quindi anche una delle sue discipline che ancora definiamo “Intelligenza Artificiale”, ne ha percorsa moltissima.

Vediamo quali sono state le strade percorse, i fattori che hanno determinato l’attuale stato dell’arte, dell’informatica in generale e di conseguenza anche della Intelligenza Artificiale (nel seguito IA).

1) Progressi nella microelettronica. Nel 1948, il primo treno espresso in Germania, il VT 08, raggiunse una velocità massima di160 km/h; oggi il nostro Frecciarossa viaggia a 300 km/h.

Il primo jetliner in servizio commerciale transoceanico, il Boeing 707, nel 1958 aveva una velocità di crociera di 977 km/h; oggi le compagnie l’hanno addirittura ridotta, per limitare i consumi.

Il Titanic, il più grande transatlantico al mondo, affondato nel 1912, trasportava 2500 persone ed era lungo 268 metri; la nave da crociera più grande del mondo, la “Icon of the Seas”, varata a gennaio 2024, porta 7600 persone ed è lunga 365 metri.

Anche per molte altre tecnologie che hanno caratterizzato il progresso nei decenni trascorsi, l’evoluzione ha avuto ritmi simili a quelli esemplificati.

All’opposto, le tecnologie informatiche, in ogni loro aspetto (densità di circuiti sul singolo chip, velocità del clock, capacità di memoria, sistemi di archiviazione permanente, architetture parallele, rapporto prezzo/prestazioni) hanno avuto ciascuna sviluppi di decine di ordini di grandezza. L’effetto combinato di questi fattori ha creato le condizioni per la diffusione planetaria dell’uso dei computer, che sono prima diventati “personal” (a casa, in ufficio, a scuola), poi sono diventati “smartphone”, legati (fisicamente e mentalmente) alla nostra persona.

2) Progressi nella comunicazione fra computer. La capacità della razza umana di comunicare (prima con la lingua parlata, poi con la scrittura, la stampa, il telegrafo, il telefono, la radio) è una delle prerogative che ne hanno permesso la “civilizzazione”.

Dal limite di 40 bit al secondo (quantità equivalente di informazione veicolata dalla comunicazione verbale umana), grazie alla connessione fra computer (tramite Internet, enormi data center in ogni parte del globo, una rete mondiale di cavi terrestri e sottomarini, ponti radio terrestri e satellitari), si è passati oggi ad una comunicazione individuale istantanea a livello planetario alla velocità media di alcuni milioni di bit al secondo, per ciascun utente.

3) Avvento degli smartphone. La disponibilità di Internet prima, poi del Word Wide Web (WWW) che ha semplificato la creazione e distribuzione di contenuti multimendiali (testo, immagini, musica, video) e infine degli smartphone, ha di fatto creato un fenomeno per certi aspetti inatteso.

Una parte rilevante della razza umana ha iniziato a produrre contenuti, creando molto rapidamente una dettagliata descrizione digitale del suo mondo. Questa descrizione è la parte più rilevante della rivoluzione in corso, perché di fatto sta creando il “manuale di specifiche” della specie umana. Contiene o conterrà presto, considerando il ritmo e il volume di inserimento dati da parte di miliardi di utenti (inconsapevoli volontari), il ricettario delle conoscenze, esigenze, preferenze, abitudini, passioni, ossessioni della razza umana.

4) Progressi nella ricerca. Sfruttando la potenza dei nuovi strumenti disponibili (computer e comunicazione) ormai più generazioni di scienziati, ricercatori, tecnici, sviluppatori di software, specialisti di varie discipline hanno reso disponibili nuovi algoritmi, effettuato scoperte scientifiche, dimostrato teoremi.

Le quattro strade indicate sopra hanno permesso all’intelligenza dell’uomo di plasmare lo sviluppo della civiltà ad un ritmo sempre più veloce, con una crescita di tipo esponenziale. Microelettronica, informatica (il termine inglese ‘computer science’ rende ancora più esplicito il ruolo scientifico di questa nuova scienza), disponibilità di dati e soprattutto IA hanno già rivoluzionato il mondo.

Gli effetti di questa rivoluzione in corso, non privi di contraddizioni, sono evidenti e sperimentati in ogni aspetto della nostra esistenza.

Esamineremo qui in particolare le implicazioni e le prospettive dell’utilizzo delle tecnologie di IA nei campi delle attività industriali e della offerta servizi, finalizzate quindi alla produzione di reddito. È importante infatti che il management di queste organizzazioni sia informato e consapevole delle opportunità offerte dai più recenti progressi dell’IA, in particolare quelli definiti “generativi” (meglio noti con la sigla GPT).

Per comprendere i principi del funzionamento di questi nuovi strumenti, è opportuno chiarire come l’IA di oggi, a differenza degli approcci seguiti nei decenni trascorsi, non sempre con risultati corrispondenti alle ambiziose aspettative dei pionieri del settore, si basi sul principio del “TRAINING”.

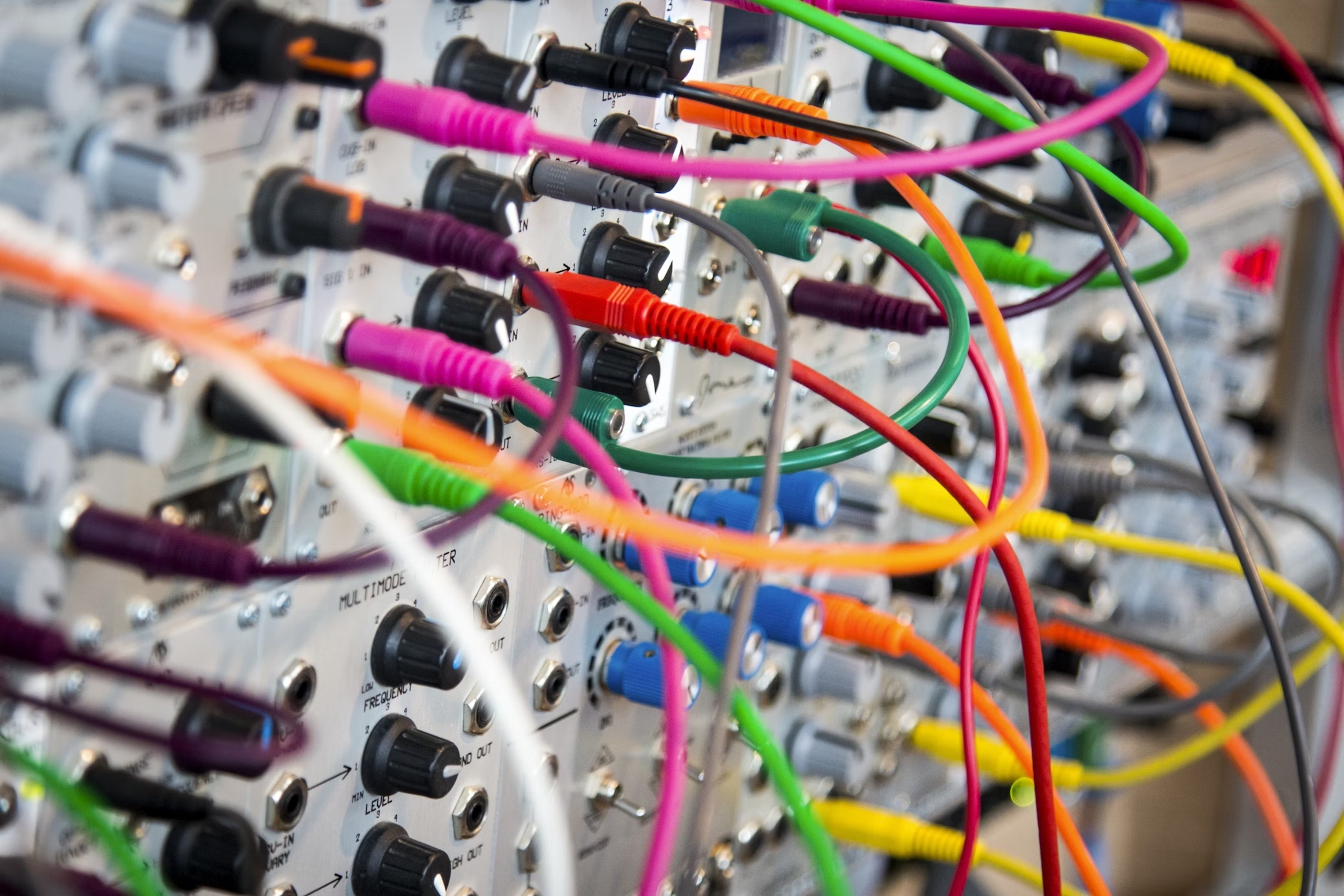

I moderni approcci teorici, derivati da metodologie matematiche, statistiche, probabilistiche, hanno dimostrato che fornendo ad appositi algoritmi (chiamati anche reti neurali artificiali) una grande quantità di dati si possono ottenere modelli utili per rispondere a numerose esigenze in vari settori applicativi. Risultati non precisi, come sarebbe possibile con metodi matematici (in termini tecnici, usando algoritmi deterministici), ma abbastanza buoni per essere praticamente utili.

Questo training, che normalmente (almeno negli anni scorsi) richiedeva interventi umani per ottimizzare i risultati, recentemente avviene in maniera autonoma, con rari o nulli interventi umani.

Il Prof. Nello Cristanini, nel suo recente libro “La Scorciatoia – Come le macchine sono diventate intelligenti senza pensare in modo umano”, utilizza il concetto di “scorciatoia” per chiarire questo nuovo approccio. Egli identifica tre “scorciatoie” (pagg. 48-49), prese lungo la strada verso la produzione del comportamento intelligente:

1 – “Sostituire i modelli teorici con regolarità statistiche”

2 – “Usare i dati disponibili piuttosto che sperare in dati annotati che non sono disponibili”

3 – “Invece che chiedere agli utenti di riempire questionari (per esprimere un loro giudizio, ndr), basta osservare i loro comportamenti, e inferire da questi le rispettive preferenze”

La nuova IA, basata su disponibilità di grandi volumi di dati e training autonomo (o quasi), ha permesso di ridurre drasticamente i costi umani. Invece di pagare delle persone per “etichettare” i dati (ad esempio distinguere una immagine di un cane da quella di un gatto o riconoscere una targa automobilistica) oggi basta fornire alla rete neurale artificiale in fase di training milioni (o meglio miliardi) di immagini; questa imparerà autonomamente a riconoscerle. Completato l’apprendimento, questa stessa rete sarà in grado di riconoscere i contenuti di nuove immagini.

Questo nuovo approccio richiede però una grande potenza di calcolo necessaria per il training del modello; da ciò derivano l’alto costo delle apparecchiature e soprattutto grandi consumi energetici, con conseguenti danni ambientali.

Altro aspetto critico: l’enorme volume di dati trattati e la natura degli algoritmi proprietari utilizzati dalle poche aziende private oggi in grado di offrire questi servizi rendono di fatto i risultati ottenuti “non tracciabili”, cioè non umanamente verificabili in caso di necessità. Questo rappresenta un importante limite nei casi che implicano rischi per salute, sicurezza, diritti umani, aspetti etici o sociali; ma anche semplicemente implicazioni legislative, contrattuali, economiche, di immagine.

In merito alle opportunità e modalità di utilizzo dei nuovi strumenti di IA, la prima considerazione è che questi sono già disponibili da tempo e ampiamente utilizzati sia sulle app per smartphone (pensiamo alle app di navigazione, agli assistenti vocali che si attivano pronunciando “Alexa” o “ok google” prima di un comando), sia nel normale utilizzo su PC aziendali.

Le raccomandazioni che ci vengono fornite nelle ricerche di notizie, prodotti, video, brani musicali o viaggi sono tutte il frutto di algoritmi di IA che in base al nostro profilo (noto in dettaglio per la stragrande maggioranza degli utenti, anche a loro insaputa) decidono i contenuti che più ci potrebbero interessare. O che hanno maggiore probabilità di generare un profitto: questa infatti è la motivazione di fondo per la gentile fornitura gratuita di servizi così utili.

Anche le classiche applicazioni di produttività individuale (Microsoft Office o simili) integrano ormai assistenti, sistemi di help contestuale, funzioni di ricerca, correzioni errori o ortografiche, tutte funzioni basate su funzionalità integrate di IA.

Ne deriva che l’investimento finalizzato a migliorare la competenza nell’uso efficiente delle normali applicazioni aziendali sia il primo passo raccomandato per accrescere la produttività complessiva di ogni organizzazione.

Una seconda considerazione, o meglio raccomandazione, è di approfondire la conoscenza dei moderni prodotti della già menzionata categoria “generativa”: ChatGPT o simili per quanto riguarda la generazione di testi, vari altri strumenti per quanto riguarda generazione di immagini, musica, video.

Sono in genere strumenti molto potenti, che se usati in modo competente e consapevole possono portare a guadagni enormi di produttività. Concentrandosi sulla generazione di testi, questi strumenti sono ormai offerti da varie aziende e utilizzano Large Language Models (LLM, l’insieme di regole usato per produrre i testi) di diversa provenienza, quindi con caratteristiche diverse. Essendo disponibili gratuitamente o con costi mensili moderati, è opportuno sperimentare i prodotti dei vari fornitori per trovare quello più adatto alle proprie esigenze. Molto utili per riassumere testi (ad esempio minute di riunioni, associandoli ad esempio a sistemi di riconoscimento vocale) o per scrivere semplici testi generici (scorrevoli, sintatticamente corretti) come messaggi di mail, paragrafi su argomenti specifici e ben descritti nel prompt (il comando nel quale si formula la richiesta). Sono quindi strumenti che se usati con competenza e consapevolezza dei limiti possono incrementare significativamente la produttività nella normale operatività quotidiana. Anche per questi strumenti, l’investimento in formazione strutturata è raccomandato.

Ulteriori considerazioni o raccomandazioni vanno naturalmente indirizzate in base ai settori specifici di interesse aziendale: ad esempio i servizi di assistenza clienti, necessità tipica per la maggior parte delle aziende, possono beneficiare della capacità di generare “colloqui” con assistenti virtuali che si sviluppano in base alle esigenze dell’utente.

Sono poi numerosi gli ambiti in cui la grande disponibilità di dati aziendali (su vendite, costi, ricavi, contabilità, produzione, logistica, qualità) può essere sfruttata per “addestrare” modelli dai quali ottenere indicazioni utili ad ottimizzare ogni aspetto della gestione aziendale.

Oppure, in ambito manifatturiero o logistico, lo sfruttamento di sistemi robotici, dotati di capacità di riconoscimento oggetti, manipolazione e movimentazione materiali, è un’attività che beneficia dei grandi progressi della IA e i cui costi sono oggi alla portata anche delle aziende di media dimensione.

Nelle aziende dove è presente anche una limitata capacità di sviluppo autonomo di soluzioni software, potrà essere utile considerare la disponibilità di strumenti di sviluppo di soluzioni IA, a costi contenuti o anche gratuiti, che permettono di avviare un percorso di acquisizione di nuove competenze e che nel prossimo futuro diventeranno la base della normale operatività aziendale, la linfa vitale della sua stessa sopravvivenza.

La rivoluzione dell’era digitale, della società basata sulla diffusa disponibilità e trattamento delle informazioni, è nata con i computer elettronici ed il software nei primi anni ‘50 dello scorso secolo. L’IA, che come abbiamo visto è nata nominalmente dopo pochi anni, non ha prodotto per decenni risultati dirompenti, se non in alcuni limitati settori.

Ma in poco più di un anno, simbolicamente dall’annuncio di ChatGPT 3.5 a fine 2022, l’IA è come esplosa nei media, nell’opinione pubblica, nella realtà. Come la cenere ardente che genera improvvisamente il plasma della fiamma quando raggiunge la temperatura di combustione, così è esplosa improvvisamente la rivoluzione, ora pienamente in azione, soprattutto in rapida diffusione.

Le conseguenze saranno dappertutto, difficilmente prevedibili. In azienda, nella vita personale e sociale, nel futuro stesso del pianeta e dell’umanità. Possiamo, dobbiamo essere preparati e consapevoli.

Abbiamo creato macchine potenti, ultra intelligenti. Sono strumenti potenti, quindi vanno usati con competenza, attenzione, consapevolezza: sta a noi saperli usare a nostro vantaggio, conoscendone potenzialità e limiti.

All’alba di Internet e del World Wide Web i presupposti erano che sarebbe stato uno strumento indipendente dai fornitori (perché basato su protocolli di comunicazione standard e open source) utilizzabile per il libero scambio di informazioni, senza interessi commerciali. È andata diversamente.

L’informatico Irving John Wood, professore del Trinity College di Oxford, nell’articolo del 1965: “Speculations Concerning the First Ultraintelligent Machine” ha scritto: “La prima macchina ultra-intelligente è l’ultima invenzione che l’uomo dovrà mai fare”.

Molte delle previsioni formulate dai pionieri dell’IA si sono dimostrate del tutto errate. Speriamo che anche questa sua previsione si dimostri falsa!